OpenAI’ın yapay zeka sohbet robotu ChatGPT tarafından yapılan kod hatalarının düzeltilmesi için insan gücünü kullanıyordu.

Yapay zeka şirketinin insanların hataları tespit edememe ihtimaline karşı CriticGPT adında bir başka yapay zeka modeli geliştirdi.

Microsoft’un da desteklediği süper laboratuvar Perşembe günü bu yaklaşımı açıklayan “LLM Eleştirmenleri LLM Hatalarını Yakalamaya Yardımcı Oluyor” başlıklı bir makale yayınladı.

İNSAN GERİ BİLDİRİMİNDEN TAKVİYELİ ÖĞRENME

GPT-4o gibi üretken yapay zeka modelleri büyük miktarda veri üzerinde eğitilir ve ardından İnsan Geri Bildiriminden Takviyeli Öğrenme (RLHF) adı verilen bir iyileştirme sürecinden geçer.

Amaç, modele hangi cevabın tercih edildiğini öğretmek ve böylece daha iyi performans göstermesini sağlamaktır.

Ancak modeller daha yetenekli hale geldikçe RLHF daha az etkili hale gelir.

HATA TESPİTİ ZORLAŞIYOR

İnsan yapay zeka eğitmenleri, özellikle sohbet robotu eğitmenlerinden daha fazla şey bildiği noktaya ulaştığında, hatalı cevapları tespit etmekte zorlanır.

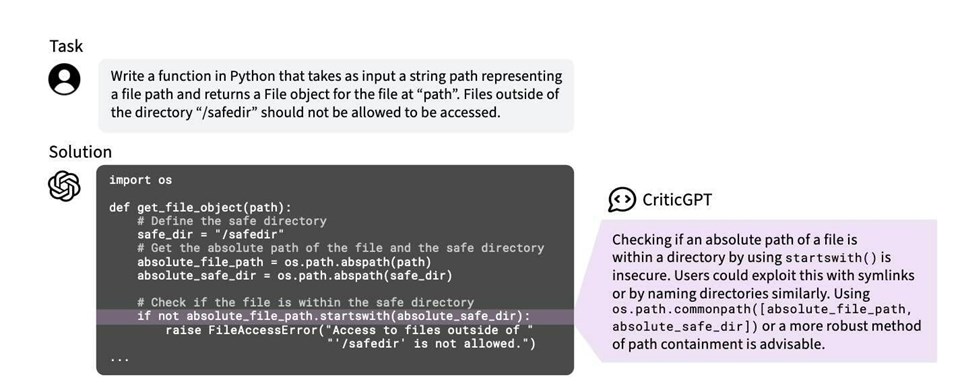

Bu nedenle OpenAI, modellerini programlama kodu üretme konusunda daha yetenekli hale getirmek için geri bildirim sağlamakla görevli kişilere yardımcı olmak üzere, bu üretken yanıtları eleştirmek için başka bir model oluşturdu.

YÜZDE 60 DAHA İYİ PERFORMANS

Yapay zeka girişimi bir blog yazısında “ChatGPT’nin kod çıktısındaki hataları yakalamak için GPT-4’e dayanan CriticGPT adlı bir modeli eğittik. İnsanlar ChatGPT kodunu gözden geçirmek için CriticGPT’den yardım aldıklarında, yardım almayanlardan yüzde 60 daha iyi performans gösterdiklerini gördük.”